- バックアップ一覧

- 差分 を表示

- 現在との差分 を表示

- ソース を表示

- 7.実践編 へ行く。

- 1 (2010-07-14 (水) 17:40:14)

- 2 (2010-07-14 (水) 20:19:44)

- 3 (2010-07-15 (木) 00:07:29)

- 4 (2010-07-15 (木) 13:41:50)

- 5 (2010-07-21 (水) 12:27:05)

- 6 (2010-07-21 (水) 23:23:55)

- 7 (2010-07-22 (木) 00:52:46)

- 8 (2010-07-22 (木) 10:15:00)

- 9 (2010-07-22 (木) 12:34:39)

- 10 (2010-07-22 (木) 13:53:00)

- 11 (2010-07-22 (木) 20:51:23)

- 12 (2010-07-23 (金) 09:25:49)

- 13 (2010-07-23 (金) 16:05:34)

- 14 (2010-07-27 (火) 15:11:07)

- 15 (2010-07-29 (木) 15:29:22)

- 16 (2010-08-16 (月) 11:59:53)

- 17 (2011-07-13 (水) 20:38:34)

- 18 (2011-07-20 (水) 20:49:05)

- 19 (2011-07-21 (木) 11:32:31)

- 20 (2011-07-21 (木) 15:17:08)

- 21 (2011-07-26 (火) 14:31:02)

- 22 (2011-07-27 (水) 19:24:22)

- 23 (2011-07-28 (木) 18:10:42)

- 24 (2011-07-30 (土) 16:29:58)

- 25 (2011-07-31 (日) 17:41:32)

- 26 (2012-06-20 (水) 16:43:09)

- 27 (2012-11-01 (木) 21:18:14)

- 28 (2013-02-17 (日) 10:03:31)

- 29 (2013-05-14 (火) 00:36:08)

- 30 (2013-06-19 (水) 20:46:21)

- 31 (2013-07-18 (木) 09:43:32)

- 32 (2014-07-17 (木) 11:00:59)

- 33 (2014-07-18 (金) 09:03:36)

- 34 (2014-07-18 (金) 09:03:48)

- 35 (2015-07-16 (木) 11:32:39)

- 36 (2016-07-21 (木) 10:36:50)

- 37 (2016-07-28 (木) 11:32:05)

- 38 (2017-07-19 (水) 20:09:16)

- 39 (2017-07-19 (水) 20:09:46)

- 40 (2017-07-20 (木) 14:49:27)

- 41 (2017-07-24 (月) 16:23:38)

- 42 (2017-07-27 (木) 14:50:35)

- 43 (2017-07-27 (木) 18:30:54)

現在(2017-08-03 (木) 11:54:42)作成中です。 既に書いている内容も大幅に変わる可能性が高いので注意。

神戸大学 大学院システム情報学研究科 計算科学専攻 陰山 聡

【目次】

2次元並列化 †

- 引き続き、正方形領域の熱伝導問題(平衡温度分布)を解く例題を扱う。

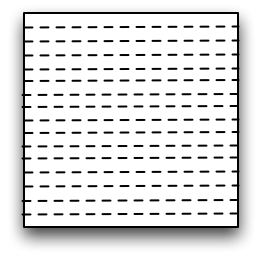

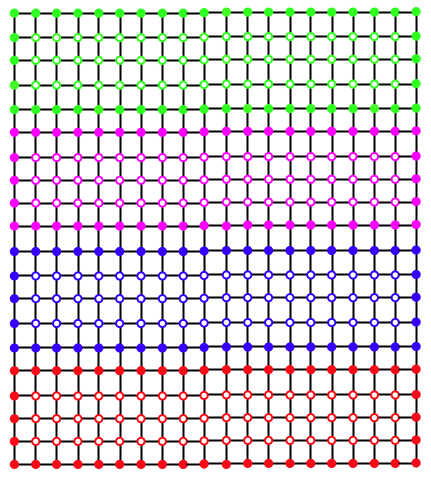

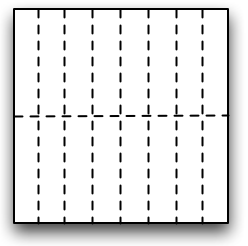

- これまでMPIで並列化を行うにあたり、正方形領域のy方向(j方向)に複数の領域に分割し、 それぞれの領域に一つずつMPIプロセスを割り当てて並列化していた。 このような並列化を1次元領域分割による並列化という。 下の図は正方形領域を16個の領域に分割した例である。

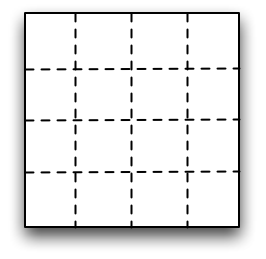

- 同様に二次元領域分割による並列化も考えられる。 正方形を16個の領域に2次元的に分割すると下の図のようになる。

- 上の二つの図はどちらも16個のMPIプロセスで並列化しているので、 計算速度の点で見ればどちらも同じと思うかもしれない。

- だがそれは違う。 プロセス間の通信にかかる時間がゼロであれば、そのとおりだが、実際にはプロセス間の通信(MPI_SENDやMPI_RECV等)には有限の―それどころかかなり長い―時間がかかる。

- では、プロセス間通信に長い時間がかかるという前提の下で、 1次元領域分割と、2次元領域分割ではどちらが計算が速いであろうか? 2次元領域分割にも様々な分割方法があるが、その中で最も最適な分割方法な何であろうか?

計算と通信 †

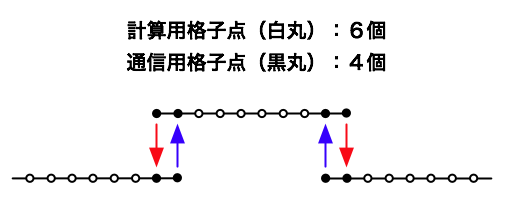

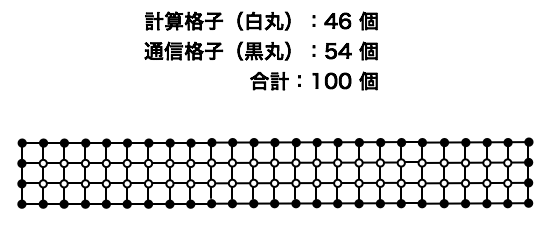

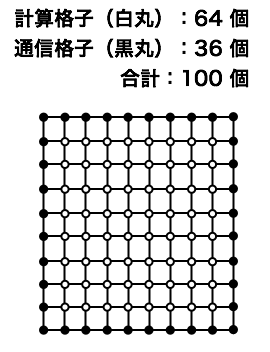

- 1次元空間を格子点で離散化した上で、MPIでプロセス間通信を行う場合を考える。

- 計算格子には2種類ある。一つは、その上で計算だけを行う格子。 もう一つはMPI通信のデータを送ったり、受けたりする格子である。 (一番外側から2番目の格子は計算も通信も行う。)

- 一つのMPIプロセスが行う通信の量は、通信を行う格子点の数に比例する。 通信に時間がかかる場合、通信を行う格子点は少ないほうが望ましい。

1次元領域分割と2次元領域分割 †

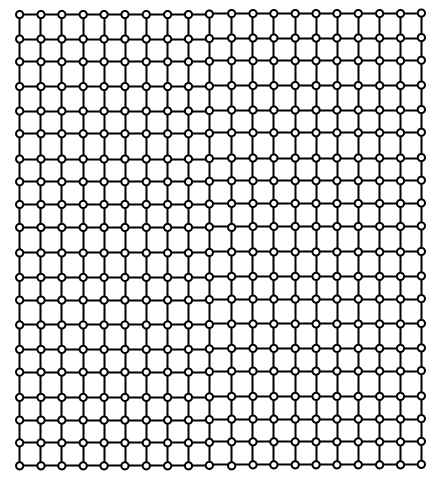

- 下の図は正方形領域を400個の格子点で離散化した場合を示す。

- これを4つのMPIプロセスで並列化することを考える。 1次元領域分割の場合、下の図のようになる。

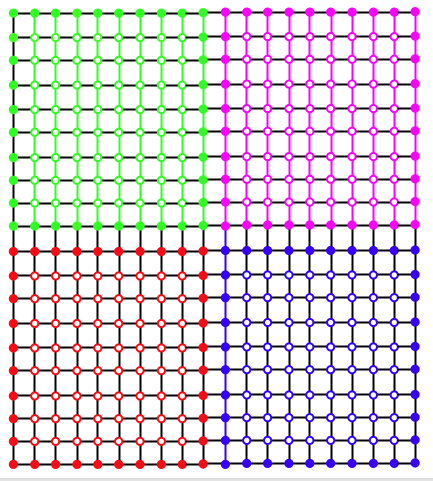

- 2次元領域分割の場合、同じく4つのMPIプロセスで並列化すると、下の図のようになる。

- 明らかにプロセスあたりの通信量は2次元領域分割の方が少ない。

2次元領域分割の方法 †

- 同じMPIプロセス数による2次元領域分割でも様々な可能性がある。 たとえば、正方形を16個の長方形に分割する場合、次の二つではどちらが通信量が少ないであろうか?

- 正方形を16個に分割するのだから、どちらも方法でも一つのMPIプロセスが担当する面積は等しい(最初の正方形の16分の1)。 だが、下の二つの図を見ればわかるとおり、長方形よりも正方形に近い方が通信量が少ない。

- 面積の等しい長方形の中で、4辺の長さの合計が最も小さいものは正方形である、ということを考えれば自明であろう。

授業アンケート †

今回の演習内容はどうでしたか?(どれか一つ、一度だけ押してください。)

質問、コメントなど自由にどうぞ †

「お名前」欄は空欄で可。

コメントはありません。 コメント/7.実践編?

as of 2025-07-02 (水) 16:03:10 (7722)